本文目录一览:

- 1、怎样才能让百度搜索不到指定网站

- 2、百科参考网上线有一段时间了,就是没有收录,仅有首页收录而已,怎么提高...

- 3、如何阻止百度baidu爬虫和谷歌蜘蛛抓取网站内容

- 4、百度统计在哪里查蜘蛛爬行的轨迹

怎样才能让百度搜索不到指定网站

1、首先,复制以下链接打开此网页。http:// 打开后,在网址旁边输入自己的网址。提交一个网站,只需要提交网站首页即可。”终于点击了。提交”。提交成功后,会弹出一个成功窗口。

2、·先联系这些网站的管理员,要求他们删除相关网页。只要原网站删除,这些内容会在几周内从百度自动消失。

3、不要在百度站长平台提交自己的网站链接就可以了。百度搜索到网站,是因为在百度站长平台提交过的的网站才能搜索到。百度站长平台是全球最大的面向中文互联网管理者、移动开发者、创业者的搜索流量管理的官方平台。

百科参考网上线有一段时间了,就是没有收录,仅有首页收录而已,怎么提高...

第一点,内容的原创度,你的文章内容是不是在互联网上面有很多相似的内容这个很关键。

友情链接也是一个不错的选择,可以选择同行业网站交换链接,尽量选择百度友好度高的网站,这会提高网站的权重,使网站收录更容易。

网站空间问题 网站空间对网站收录来说是很重要的,如果你的网站收录出问题,你需要确认下你的网站空间是否存在问题。

如何阻止百度baidu爬虫和谷歌蜘蛛抓取网站内容

直接过滤蜘蛛/机器人的IP段。注意:第二项措施只对“君子”有效,第三项措施要用来防“小人”(“君子”和“小人”一般分别指遵守robots.txt协议的蜘蛛/机器人)。

总结起来,每个网站的难度都不一样,99%数据是可以抓取到的。百度就是国内最大的爬虫,所以想要完全禁止的,除非服务器关了,数据删了。否则要采集的手段太多了,无外乎就是出于成本上的考虑。

浏览者能看见内容 但是无能有效复制,无法通过底层协议抓取 6混淆算法随时改变,只需要放入新素材就可以了,不需要工程师参与。

不再允许搜索引擎的蜘蛛抓取你的内容具体方法可查看这里 http://看见那个没?“为搜索引擎准备的内容代码如下,替换成你自己站点的内容就可以:允许搜索机器人搜索站内所有链接。

允许抓取网页和gif格式图片 Sitemap:网站地图 告诉爬虫这个页面是网站地图 robot文件的常见用法 例 禁止所有搜索引擎访问整个网站。User-agent:Disallow: / 例禁止百度蜘蛛访问整个网站。

百度统计在哪里查蜘蛛爬行的轨迹

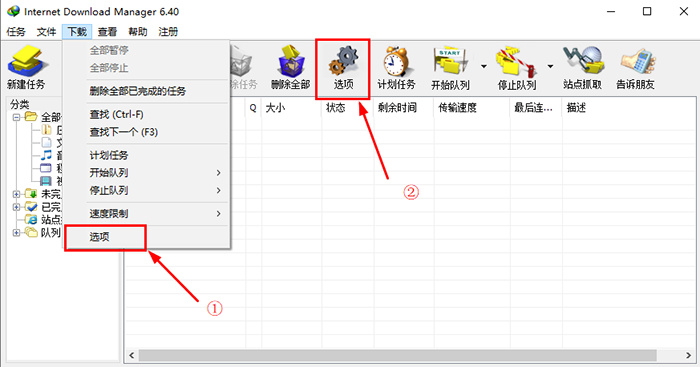

1、首先tongji.baidu.com登录百度推广后台,点击最上面的导航【实时访客】在【实时访客】中找到来路地域,关键词,网址,停留时间。

2、而需要进行抵达率统计的一般是搜索关键词的统计,推广数据的统计,和对主机的检测。那么在百度推广的客服那里,就可以得到账户指定关键词和创意的抵达率,跳出率等准确数据。

3、百度联盟用户请在http://union.baidu.com/登陆系统,找到“百度统计”链接并且点击进入 如果您不是百度推广或联盟用户也可以直接登录百度统计首页http://tongji.baidu.com/。

4、第二:注意网站页面的更新度和更新频率 事实上,每次蜘蛛抓取网站时,都会将这些页面的数据存储在数据库中。下次蜘蛛再次爬网时,它会与上次爬网的数据进行比较。

转载请注明:商兜网 » 网站建设 » baiduspider(baiduspider python)

版权声明

本文仅代表作者观点,不代表B5编程立场。

本文系作者授权发表,未经许可,不得转载。