本文目录一览:

谷歌爬虫提示无法连接服务器

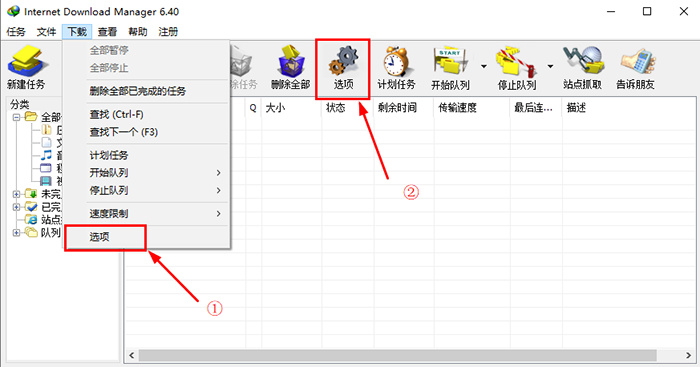

1、该问题是因为chrome浏览器设置不当导致的,通过重置以后能解决,步骤如下:直接打开对应窗口,找到图示按钮并点击跳转。下一步弹出新的界面,需要选择显示高级设置进入。这个时候如果没问题,就继续在那里确定重置设置。

2、需要连接到国际网络,才能连接到谷歌的服务器,访问谷歌商店,并且在运行Google Play之前,Android手机还需要安装谷歌框架。

3、网络连接故障:网络连接故障是导致无法连接服务器的最常见原因。网络连接故障可能是由于网络设备故障、网线松动、无线网络信号不稳定等原因造成的。

爬虫一般采用什么代理ip

- 付费代理IP:付费代理IP的质量相对较高,而且可以保证稳定性和可用性,但是需要花费一定的费用 。

代理IP也是分类的,最常用的代理IP类型有SOCKS代理、HTTPS代理、HTTP代理等。按时效可分长效和短效,在行业法规允许范围内,长效代理IP可以进行一些例如搜索资料数据以方便了解行业数据的爬取任务。

什么样的IP的代理的话可以用来做那种爬虫的采集,你要选择的话肯定就是根据那个性质的决定来改变的。

爬虫使用代理i爬是非常常见的一种形式,因为有反爬虫的限制,我们要避免这种行为给我代理的工作压力。在选代理ip的时候可以通过以下几个方面进行。

python中,进行爬虫抓取怎么样能够使用代理IP?

以下是一些常用的代理IP获取方式:- 免费代理IP:可以通过一些公开的API接口或者网站来获取,但是免费代理IP的质量参差不齐,有些甚至会被封禁,所以使用时需要谨慎 。

搭建代理池服务器 我们可以使用Python语言来搭建代理池服务器。具体来说,我们需要使用Flask框架来编写一个简单的Web应用程序,用于接收代理IP地址的添加、删除和查询请求。

另外我们需要先获取一个可用代理,代理就是 IP 地址和端口的组合,就是 : 这样的格式。如果代理需要访问认证,那就还需要额外的用户名密码两个信息。

爬虫一般采用代理IP来进行网络请求,以隐藏真实IP地址并避免IP被封锁。在网络爬虫的使用中,代理IP扮演着重要的角色。网络爬虫是一种自动化程序,用于从互联网上抓取、收集数据。

Python爬虫是从事大数据工作者经常会接触的,那么使用爬虫必然需要使用到IP代理去解决反爬虫机制,我们在获取目标网站的网页数据信息时,常常会遭受到对方服务器的反爬机制的困扰。

如何用爬虫爬网络代理服务器地址

把有效的ip写入ip代理池的配置文件,重新加载配置文件。让爬虫程序去指定的dailiy的服务ip和端口,进行爬取。

爬虫工具:通过爬虫工具自动爬取公开代理网站上的IP地址并保存到本地文件中,例如使用Python的requests库和BeautifulSoup库进行爬取。

如果你下面那个可以使用个,你就都加上代理就是了,应该是有的网站限制了爬虫的头部数据。 虽然你可以通过urlopen返回的数据判断,但是不建议做,增加成本。

第一步:找IP资源 IP资源并不丰富,换句话说是供不应求的,因此一般是使用动态IP。免费方法,直接在网络上找,在搜索引擎中一搜索特别多能够提供IP资源的网站,进行采集即可。

运行结果中的 origin 若是代理服务器的 IP,则证明代理已经设置成功。 如果代理需要认证,那么在代理的前面加上用户名和密码即可,代理的写法就变成如下所示: 这里只需要将 username 和 password 替换即可。

基本步骤发现可读且可访问的URL。浏览种子或URL列表以识别新链接并将它们添加到列表中。索引所有已识别的链接。使所有索引链接保持最新。很多网站都具有反爬虫策略,常见的方式有:验证码、登陆、限制IP等。

转载请注明:商兜网 » 主机域名 » 爬虫代理服务器(搭建爬虫代理服务器)

版权声明

本文仅代表作者观点,不代表B5编程立场。

本文系作者授权发表,未经许可,不得转载。