本文目录一览:

如何访问b站的robots.txt?

也就是说robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。

机器人放在服务器的根目录下,所以如果你想查看,只要在IE上输入http://yourwebsite/robots.txt即可。如果想检查分析机器人,有专业的相关工具。

登陆网站后台FTP,robots文件就在站点的根目录下面,直接使用查找输入r就可以找到,如果没有找到的话,可能设置的隐藏,强制现实文件即可,还有一种原因就是网站没有robots文件,不是所有的建站系统都自带robots文件的。

robots.txt文件查看的话,如果是自己的网站,只要用记事本打开就可以了;如果是别人的网站的robots.txt就需要借助一些工具来查看了。

robots.txt必须放在一个站点的根目录下,文件名必须全部小写。robots.txt文件的格式 用户代理:定义搜索引擎的类型。 不允许:定义禁止被搜索引擎包括的地址。 允许:定义允许被搜索引擎包含的地址。

网站里的“robots”文件是什么意思?

1、robots是一个协议,是建立在网站根目录下的一个以(robots.txt)结尾的文本文件,对搜索引擎蜘蛛的一种限制指令。

2、robots.txt文件,SEOER们都知道,就是可以设置你网站的哪些内容允许蜘蛛抓取,哪些不允许蜘蛛抓取的一个文件。今日,据百度站长平台最新消 息,用户在百度搜索网址或相关关键字时,网页搜索结果会出现robots提示。

3、robots是英语中的一个词汇,意思是“机器人(们)”。

4、robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。Robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

robots文件怎么设置Robots文件

网站改版正确使用robots文件的方法是:在改版期间,将robots文件设置为“disallow: /”以阻止搜索引擎访问网站,然后在改版完成后,根据新网站的结构和内容,更新robots文件以允许搜索引擎重新访问网站。

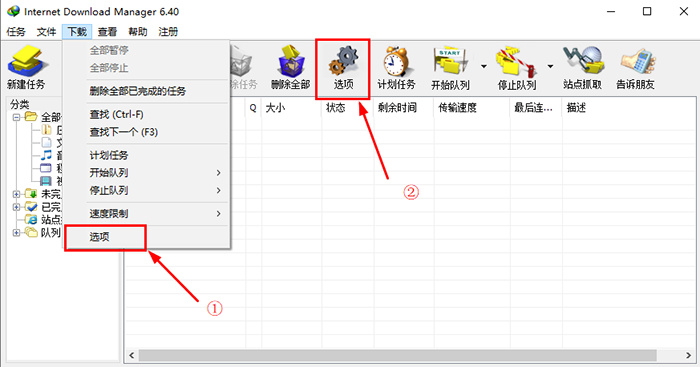

你可以通过FTP找到robots. txt文件,下载到本地修改后再上传。主要是屏蔽不让搜索引擎抓取的文件夹目录,你可以通过FTP查看所有文件夹对照网站栏目来设置,如果还不知道如何操作可以,参考米拓建站官网的robots.txt文件。

首先,我们需要创建一个robots.txt文本文件,然后在文档内设置好代码,告诉搜索引擎我网站的哪些文件你不能访问。

robots符号介绍 首先我们先来认识一下书写robots时常用到的几个字符 User-agent:写义搜索引擎类型,这里的首字母要大写U,结尾冒号:后要加一个空格键,如 User-agent:* 不带空格,User-agent: * 带空格的。

搜索引擎来网站抓取内容的时候,首先会访问你网站根目录下的一个文本文件robots.txt,搜索引擎机器人通过robots.txt里的说明,来理解该网站是否可以全部抓取,或只允许部分抓取。

如果你的站点对所有搜索引擎公开,则不用做这个文件或者robots.txt为空就行。2 必须命名为:robots.txt,都是小写,robot后面加s。3 robots.txt必须放置在一个站点的根目录下。

robots.txt怎么删除

如果你想让搜索引擎收录站点的全部内容,robots.txt 文件是完全可以删除的。推荐用站点程序自带默认的内容就行(可以有效避免收录重复、后台敏感等内容)。

可以删掉,这是规定搜索引擎的网页机器人的动作的文件。

可以选择删除掉你的robots.txt文件,就在网站源码的根目录下。你可以去百度下robots.txt这个文件是干什么的。其实他就是防止搜索引擎搜索的一个文件。

百度无法抓取网站,因为其robots.txt文件屏蔽了百度。方法:修改robots文件并取消对该页面的阻止。机器人的标准写法详见百度百科:网页链接。更新百度站长平台(更名为百度资源平台)上的网站机器人。

转载请注明:商兜网 » 网站建设 » robots.txt(robotsTXT不支持的代码)

版权声明

本文仅代表作者观点,不代表B5编程立场。

本文系作者授权发表,未经许可,不得转载。